컨테이너 환경을 바꾸어 보았다.

람다 -> ECS + Fargate

이미지: DockerHub 이용하기

알고보니 GPU를 이용하려면 EC2를 이용해야 하는 것이었고,

GPU를 사용하는 경우 엄청 비싸기 때문에 그냥 Fargate로 사용해보기로 했다.

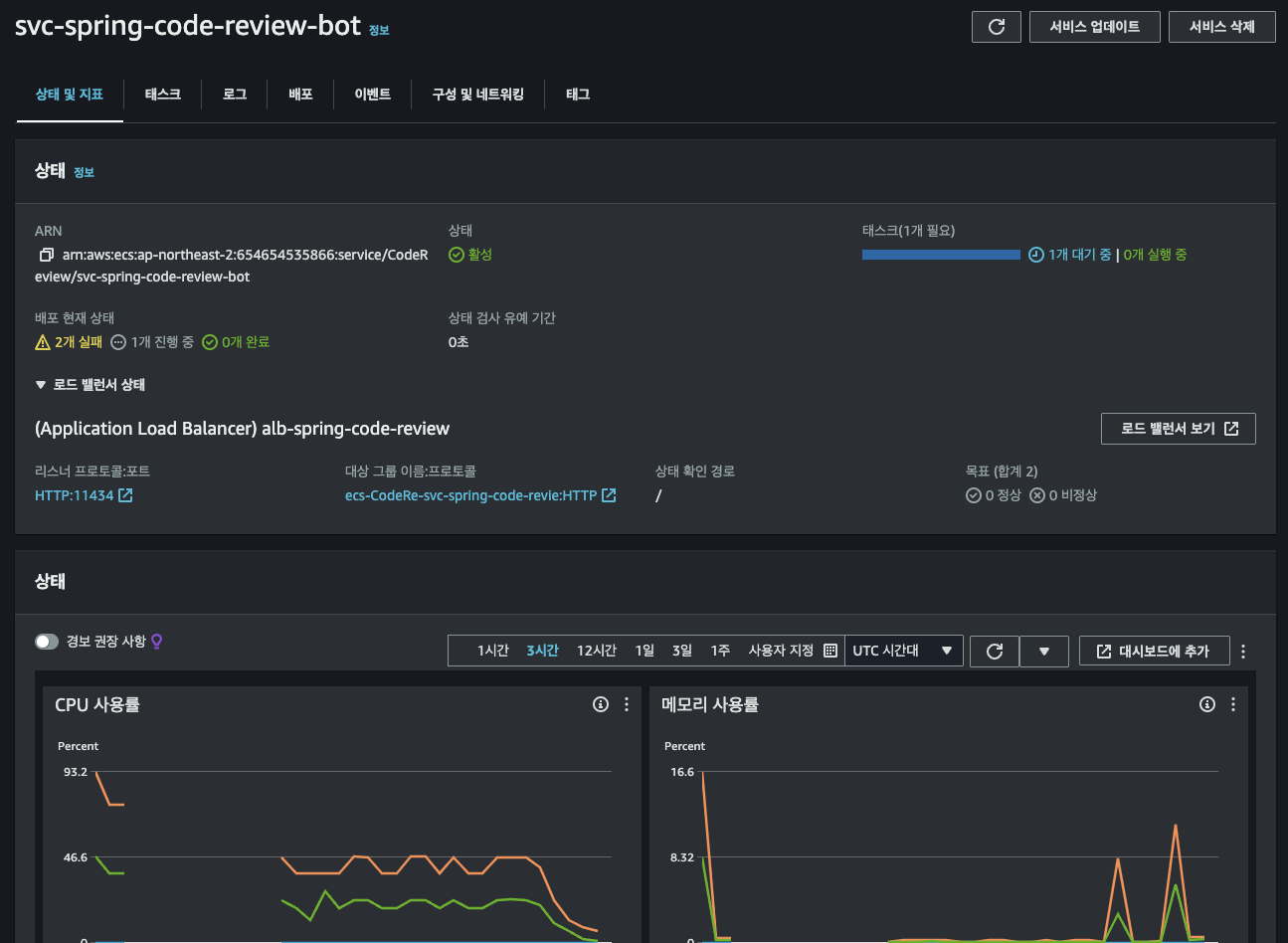

처음에는 2vCPU + 16GB를 줬었는데, 배포가 잘 되지 않았다.

혹시나 하고 4vCPU + 30GB를 배정해줬는데도 불구하고 배포 되면 죽고, 배포 되면 죽고의 반복이었다.

그렇다고 해서 컨테이너 자체의 로그를 볼 수 있는 부분인 CloudWatch 내 로그 이벤트에 '실패'가 뜨는 것도 없었다.

Ollama 서버용 컨테이너 자체는 잘 동작하고 있는 것이다.

아래의 여러가지 시도를 해봤는데 되지 않았다.

- CPU 및 메모리 재설정

- 상태 확인 경로 '/'로 변경해보기

- 상태 확인 명령어 수정해보기:

"CMD-SHELL,wget -q -O - http://localhost:11434 || exit 1" - 상태 확인 간격 및 제한 시간 늘려보기

- CPU가 적어서 데드락 걸리는 건가싶어서 용량 늘려보기(최대치인 16vCPU까지 늘려봤음)

음 ... 지금은 뭐 때문인지 잘 모르겠는데...

다음에는 그냥 EC2로 한 번 이미지 실행 먼저 시켜보고 컨테이너에 재시도 해봐야겠다.

오늘 사용한 Dokerfile은 다음과 같다.

FROM ollama/ollama:latest

WORKDIR /models/llama3-1

COPY Modelfile_llama-3-Korean-Bllossom-8B-Q4_K_M .

COPY llama-3-Korean-Bllossom-8B-Q4_K_M.gguf .

# 실행 스크립트 생성

RUN echo '#!/bin/sh\n\

ollama serve &\n\

sleep 5\n\

ollama create llama-3-Korean-Bllossom-8B-Q4_K_M -f Modelfile_llama-3-Korean-Bllossom-8B-Q4_K_M\n\

exec "$@"' > /run.sh && chmod +x /run.sh

ENTRYPOINT ["/run.sh"]

EXPOSE 11434

CMD ["ollama", "run", "llama-3-Korean-Bllossom-8B-Q4_K_M"]'프로젝트 > 프로젝트 과정' 카테고리의 다른 글

| [사이드 프로젝트] 한정 수량 인기 상품 구매 서비스 만들기: 요구 사항 (0) | 2024.09.26 |

|---|---|

| GlobalExceptionHandler와 ExceptionHandlingFilter의 차이점 (0) | 2024.09.19 |

| [Fixture Monkey] 원숭이야, 테스트 값 좀 만들어 줘! (6) | 2024.09.06 |

| [실패] AWS Lambda 환경에서 Ollama를 이용한 코드 리뷰 봇 만들기 (2) | 2024.09.03 |

| [잔디일기] 랜덤 값 만들기 (0) | 2024.07.28 |